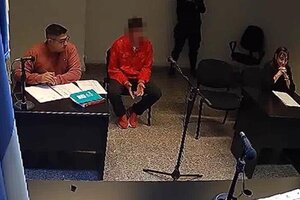

Una pesadilla. Esas fueron las palabras que usó Guillermo Federico Ibarrola para describir lo que le tocó padecer la última semana a causa de un error del sistema de reconocimiento facial que adoptó la Policía de la Ciudad para dar con personas que tienen pedido de captura. El sistema de inteligencia artificial -que procesa las imágenes de 300 cámaras de seguridad instaladas por el Gobierno porteño y las contrasta con las del registro de Consulta Nacional de Rebeldías y Capturas (Conarc)- tiene además del margen de error tecnológico un problema grave con la carga de datos, muchos de ellos erróneos.

El de Guillermo fue un caso extremo: estuvo detenido seis días y casi es trasladado a un penal por un delito que nunca cometió. Ayer a última hora, la fiscalía que intervino en el caso ordenó su liberación y le compró un pasaje de micro para volverse a su casa.

"Fue un error de la máquina”

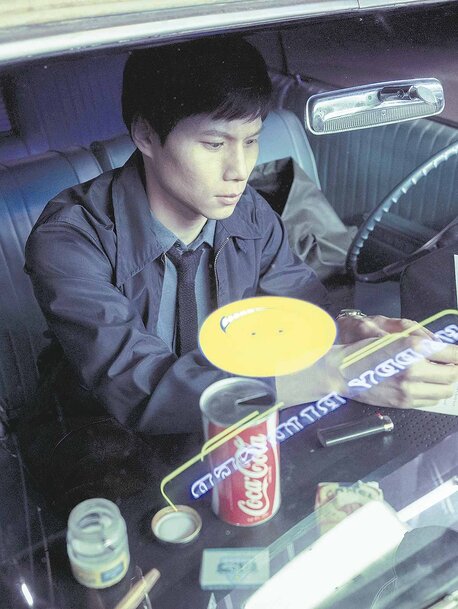

“Nunca pensé que me iba a tocar vivir algo así. Me tocó a mí pero le puede tocar a cualquiera. Fue un error de la máquina”, Guillermo habla desde la terminal de Retiro adonde llegó en micro después de haber sido traslado al juzgado de Bahía Blanca. El sábado pasado, en esa misma estación fue detenido por error. Su rostro apareció en el sistema de reconocimiento facial relacionado a un caso de robo agravado ocurrido en 2016 en la ciudad de Bahía Blanca.

Sin poder creer lo que le decían los efectivos, Guillermo comenzó a repetir algo de lo que estaba seguro: nunca había estado en Bahía Blanca y nunca había cometido ningún delito. “Dos policías se me acercan, me detienen, me piden el DNI y me dicen que los acompañe. Yo pensé que me iban a pedir que saliera de testigo de algo pero me dicen que quedaba demorado por una causa por robo agravado. Me llevan detenido y pasaban los días y nadie me decía nada, nadie me explicaba nada”, contó desde Retiro.

Hoy la sensación de Guillermo es de alivio, en las breves declaraciones que brindó a los medios desde la estación repite una y otra vez: “Me podían haber arruinado la vida”. Lo dice porque durante los seis días que pasó demorado nadie le daba una explicación ni información concreta. Solo le decían que iba a ser trasladado a un penal.

“Ayer mientras me estaban trasladando le sonó el teléfono a los policías. Era la fiscal que preguntaba si me estaban llevando esposado. Los policías responden que sí porque me trasladaban en calidad de detenido. Parece que ahí les dice que me cuiden y que me saquen las esposas. Me hicieron poner los cordones y cambiaron el trato, me ofrecieron café y comida. Cuando llegué a la fiscalía me explican que fue todo un error y la fiscal me compra un pasaje para volver en micro”, contó a A24.

Efectivamente el hombre buscado por la Justicia era otro: Guillermo Walter Ibarrola. Otro nombre y otro número de DNI. Pero el sistema de reconocimiento facial activó el alerta de todos modos. El error se da en medio de las críticas que recibió el sistema por los “falsos positivos”, aunque desde la Policía de la Ciudad sostienen que el margen de error es sólo del 3 por ciento.

El gobierno porteño defiende su sistema

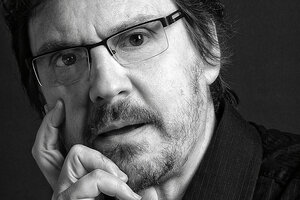

Marcelo D’Alessandro, secretario de Justicia y Seguridad de la Ciudad de Buenos Aires, defendió el sistema instalado por la policía porteña y explicó que este caso se trató de otro problema, igual o tanto más grande que el tecnológico: los errores de carga de los juzgados y fiscalías de todo el país. En este caso, dice, el DNI cargado en el registro del Ministerio de Justicia estaba mal y por eso el reconocimiento se hizo sobre la persona equivocada.

“Hay un error de interpretación y todos apuntan al sistema cuando en verdad lo que hubo fue un error de carga de los datos en el Conarc. Hay muchos errores de carga. Si al hombre le hubieran pedido el documento en la ruta también lo paraban, no fue un error del sistema”, se defendió D’Alessandro.

El funcionario explicó que el sistema reconoce los rostros de los documentos cargados en el registro de personas con pedidos de captura. Al estar mal cargado el DNI, algo que en este caso habría sido un error en la diligencia de la investigación de la policía local de Bahía Blanca, el sistema identificó al hombre equivocado. “Se quiere poner en duda al sistema y el problema es otro”, insiste el funcionario, que reafirmó que el porcentaje de “falsos positivos”, es decir, cuando el sistema falla, no supera el 3 por ciento.

El sistema de reconocimiento facial incorporado por la fuerza porteña comenzó a funcionar hace pocos meses; en este tiempo identificó a 1.300 personas. De ese número, sólo 300 quedaron detenidas por ser autores de delitos graves. El resto, depende cada caso. No está claro cuántos fueron los errores producto de la incongruencia en la carga, como el de Guillermo.

“En el pedido de captura los juzgados cargan de todo, hasta casos de rebeldía. El sistema los identifica, nosotros los detenemos y nos comunicamos con el juzgado que puede ser de cualquier provincia del país. Muchas veces nos piden que le notifiquemos que tienen una causa en trámite en la que deben presentarse y nada más”, agregó D’Alessandro.

"La base de datos está muy mal confeccionada"

Desde el Centro de Estudios Legales y Sociales (CELS) remarcaron que existen varias dudas alrededor de este tipo de sistemas en todo el mundo. Algunas relativas al margen de error que, aseguran, suele ser mucho más alto que el reconocido por el gobierno porteño, y otras relacionadas con la cuestión de fondo: el nivel desproporcionado de vigilancia.

“El sistema tiene varios errores. En primer lugar son las fallas del software sobre las que el Gobierno dice que tiene un margen muy bajo como no existe en ningún lugar del mundo. El otro es que la base de datos está muy mal confeccionada, hay mucha gente que no debería figurar. Y otro es que se está deteniendo a personas por causas muy viejas que ya incluso están cerradas”, explicó a Página/12 Andrés López Cabello, abogado del equipo de Litigio y Defensa Legal del CELS.

Como ejemplo de estas fallas, López Cabello contó que el sistema de reconocimiento facial detuvo a una mujer que había sido llamada como testigo en una causa cerrada hace varios años. La notificación para testificar nunca le llegó, la mujer nunca se presentó a testificar y por eso fue declarada en rebeldía. Fue detenida hace poco aunque su detención quedó sin efecto a las horas.

Por último, el abogado remarcó el problema de fondo que plantea la utilización de sistemas como el de reconocimiento facial. “Es la respuesta desproporcionada que tienen estos sistemas de vigilancias en nuestras vidas. En su última acordada, la Corte ordenó ser muy estrictos en cuanto al pedido de escuchas por ejemplo y eso porque no se prevé un Estado omnipresente destinado a controlar a la sociedad bajo un estado constante de sospecha”, opinó.

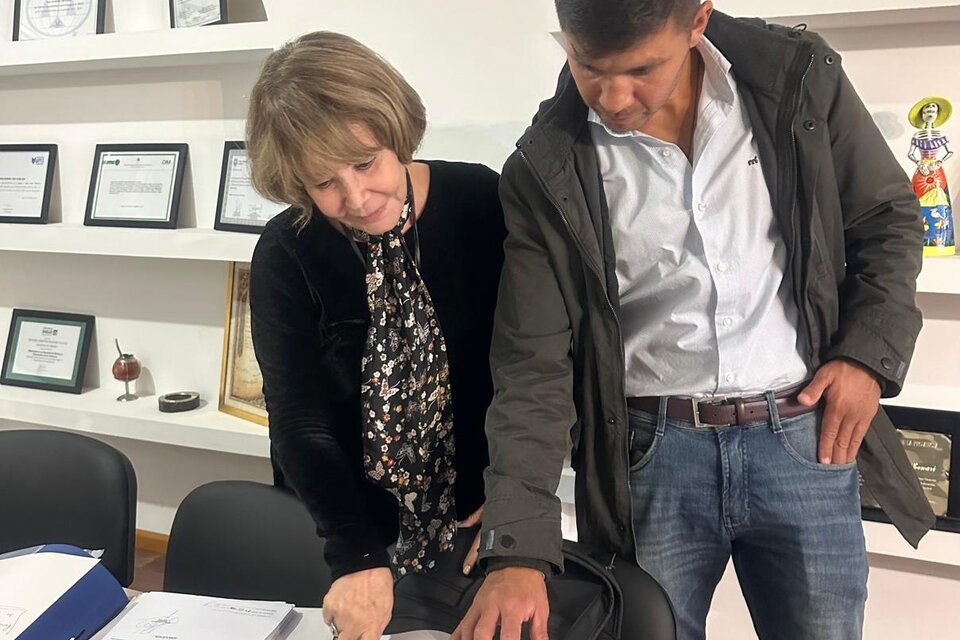

Desde la Defensoría del Pueblo, órgano que audita el sistema para velar por los datos personales, remarcaron que debió existir un estudio previo a la implementación del reconocimiento facial. “El sistema es un todo, no es sólo el algoritmo de reconocimiento de rasgos, es también la base de datos que está usando para las detenciones. Y viendo todos estos problemas con los datos del Conarc, que están muy desactualizados o mal cargados, tenemos que decir que el sistema no está funcionando”, reconoció María Julia Giorelli, abogada del Centro de Protección de Datos de la Defensoría.

El secretario de Seguridad aludió que por tratarse de un error de carga el hombre podría haber sido detenido en cualquier otro control policial. Giorelli no está de acuerdo con esto último. “Por supuesto que no se puede comparar. Acá entra a jugar la tecnología y el impacto que tiene en materia de privacidad y protección de datos es tan potente que no se puede comparar con una acción humana”, aclaró la abogada.

Para la funcionaria, todavía quedan dudas sobre el sistema de inteligencia artificial que usa el gobierno porteño. Por ejemplo, si se están manipulando los datos o si hay algún sesgo racista en la identificación de los rasgos faciales. “El impacto es fuerte y las personas tienen que estar perfectamente informadas sobre qué van a hacer con toda esta información. Nos preguntamos si no debió existir un debate parlamentario para delimitar los alcances de un software tan potente como este”, concluyó la abogada.